Что такое парсинг

Для того, чтобы поддерживать информацию на собственном сайте в актуальном состоянии, структурировать контент и наполнять каталог товарами - необходимо потратить достаточно много времени и энергоресурса. Однако существуют такие программы, способные заметно сократить затраты и частично автоматизировать некоторые процедуры, которые тесно связаны с поиском материалов и их экспортом в нужном формате. Эта процедура носит название “парсинг”.

Парсингом называют метод индексирования информации с конвертацией ее в иной формат или же иной тип данных.

Данный процесс позволяет взять некоторый файл в одном формате и преобразовать его данные в более удобную форму, которую впоследствии можно использовать для решения каких-либо задач. Так HTML-файл при помощи парсинга можно преобразовать в “голый”, понятный для простого человека, текст или же конвертировать в JSON, сделав HTML понятным для скрипта или приложения.

Существует несколько узконаправленных определений парсинга:

-

Парсинг в программировании — это автоматизированный сбор и структурирование информации с сайтов при помощи программы или специального сервиса.

-

Парсинг в маркетинге - это сбор основной информации с сайтов-конкурентов для анализа собственных веб-ресурсов.

Однако в этой статье мы рассмотрим парсинг в более узком направлении - обработке данных на веб-страницах. В этом случае парсинг представляет собой анализ текста, вычленение необходимых данных, а также преобразование их в нужный вид. Благодаря такому процессу на страницах сайта можно находить полную информацию, которую можно извлечь в структурированном виде. Выполняют эту автоматизированную работу парсеры - это различные программы или скрипты, способные сканировать необходимый сайт. Принцип работы заключается в том, что парсерам задают источники данных и параметры поиска, по которым они впоследствии и будут собирать всю информацию в таблицы, списки или базы данных.

Бывает так, что площадки блокируют подозрительные IP-адреса из-за сильной активности. Для того, чтобы парсер не заблокировали, он использует прокси-серверы, которые выступают посредниками, подменяющими IP-адрес парсера на свой, не давая тем самым сайту увидеть активность парсера.

Отсюда возникает вопрос: “Законно ли парсить?” Да, проводить парсинг сайтов с помощью парсера законно, ведь если на страницах есть публичные данные, которые можно достать вручную, то это можно сделать и автоматизировано. Но существуют некоторые ограничения:

-

запрещается перегружать чужие веб-страницы до полной или частичной неработоспособности;

-

нельзя распространять личные данные, собранные при помощи парсинга;

-

нельзя использовать парсинг с целью плагиата или спама.

Основные задачи, которые помогает решить парсер

При использовании парсера можно достать практически любую информацию с сайта. Однако существует ряд направлений, в которых данные инструменты используются чаще всего:

-

Мониторинг цен в каталогах конкурентов. Вы можете отслеживать стоимость товаров и услуг конкурентов с целью корректировки прайса собственного интернет-магазина или создания более выгодного предложения своим клиентам. Также парсер цен может использоваться с целью актуализации стоимости товаров на сайтах поставщиков.

-

Поиск товарных позиций. Данная опция становится полезна в том случае, когда сайт поставщика не способен автоматически переносить базу данных с товарами. В этом случае Вы можете запросить необходимую информацию по определенным критериям и быстро перенести ее на свой ресурс (Вам не придется переносить каждую товарную единицу вручную).

-

Извлечение метаданных. Обычно специалисты по SEO-продвижению используют данные программы для того, чтобы скопировать у конкурентов содержимое тегов description, title и другие. Еще одним немаловажным элементом является парсинг ключевых слов (ключей). Он является одним из наиболее эффективных способов аудита сайта-конкурента, что позволяет в короткие сроки внести все необходимые изменения на собственный ресурс для более ускоренного получения результата.

-

Аудит ссылок. Иногда парсеры используют для обнаружения некоторых проблем на странице. Специалисты настраивают программу под поиск конкретных ошибок и запускают, чтобы в автоматическом режиме обнаружить все нерабочие ссылки, редиректы и страницы ресурса.

Также существует, так называемый, серый парсинг. Суть его заключается в скачивании и копировании полностью сайта или контента конкурента. Но дело здесь совершенно не в парсинге, а в том, как специалисты распоряжаются добытым материалом. Невозможно просто “украсть” сайт без последствий, поскольку авторские права никто не отменял.

Однако мы будем говорить только о “белом” парсинге, используя который, к Вам не возникнет никаких вопросов.

Зачем нужен веб парсинг и когда его используют?

Иногда люди задаются вопросом :”Какие есть способы парсинга сайта?”Весь процесс парсинга можно разделить на 2 типа:

Технический парсинг, который используют SEO-специалисты для выявления различных проблем работы сайта:

-

поиск некорректных редиректов 30* и битых ссылок;

-

выявление дублей и проблем с мета тегами Title, Description, а также заголовками H1;

-

для анализа работы Robots.txt;

-

проверка настройки микроразметки на сайте;

-

поиск нежелательных страниц, открытых для индексации;

-

решение прочих технических задач.

На основе полученных данных, специалист последствии составляет техническое задание для устранения выявленных проблем.

Парсинг данных, направленный на развитие собственного бизнеса:

-

сбор информации об ассортименте, представленном у конкурентов;

-

парсинг названия товаров, цен и артикулов собственного каталога с целью мониторинга данных;

-

анализ структуры сайтов конкурентов с целью улучшения и развития структуры собственного интернет-ресурса.

Все вышеперечисленные примеры являются лишь малой частью того, где может быть использован парсинг. Область применения может ограничиваться лишь вашей фантазией и некоторыми техническими особенностями.

Как найти парсер

Найти программу для поиска и преобразования можно четырьмя способами:

-

Использовать силы разработчика. Если в вашей команде есть толковый программист, способный создать парсер, адаптированный под все потребности компании, то и искать другие варианты совершенно не придется.

-

Установить готовое приложение-парсер на свой ПК. Да, такие программы также будут стоить определенное количество денег, но зато Вы сразу получите готовый продукт. Настройки необходимых параметров позволяют точно выстроить схему парсинга.

-

Воспользоваться интернет-ресурсом с аналогичными функциями, что и в приложении на ПК. В этом случае можно встретить бесплатную версию.

Если у Вас нет возможности создать собственную версию парсера (нет программиста в штате), то наиболее удачным вариантом станет использование десктопной версии. Однако, если перед Вами стоят совершенно несложные задачи, Вы сможете вполне обойтись и браузерным плагином.

Основные преимущества парсинга

По сравнению с ручным методом сбора информации, у автоматического способа намного больше преимуществ:

-

программа может работать самостоятельно без вашего присутствия. Вам не придется тратить время на поиск и самостоятельную сортировку данных. Да и собирает данные она намного быстрее в режиме 24/7 (если вам это требуется);

-

для парсера можно задать ровно столько параметров, сколько вам требуется и идеально настроить его так, чтобы искался необходимый контент (без лишнего мусора и нерелевантных страниц);

-

парсер не допустит ошибок из-за своей “невнимательности” и никогда не устанет;

-

парсеры распределяют нагрузку на сайт таким образом, чтобы случайно “не уронить” чужой ресурс.

Исходя из вышеперечисленного можно сделать однозначный вывод: нет никакой необходимости парсить вручную то, что может сделать за вас компьютер.

Недостатки парсинга

Помимо преимуществ, у данного способа сбора информации есть и свои недостатки. Главным из них является заключается в том, что иногда ими не удается воспользоваться. Это происходит лишь по той причине, когда владельцы сайтов закрывают свои ресурсы от автоматического сбора информации со страниц. Сегодня существуют сразу несколько способов блокировки доступа со стороны парсеров: при помощи настроек для поисковых ботов и по IP-адресам. И все они достаточно надежно защищают сайты от парсеров.

К минусам метода можно отнести и тот факт, что парсинг могут использовать и конкуренты. Для того, чтобы защитить свой ресурс, необходимо прибегнуть к одной из следующих техник:

-

заблокировать запросы, указав необходимые параметры в robots.txt;

-

настроить капчу. Обучить парсер обходить графические изображения достаточно затратно, поэтому никто этим заниматься не будет.

Однако все методы защиты очень просто обойти, поэтому с таким явлением проще всего смириться.

Алгоритм работы программы

Работа парсера заключается в следующем: он проводит анализ контента страницы по заданным параметрам, а затем извлекает его в виде систематизированных данных.

Сам процесс работы с приложением выглядит так:

-

пользователем вводятся все исходные данные для парсинга;

-

указываются необходимые страницы или ресурсы, на которых нужно провести поиск информации;

-

после этого программа проводит глубокий анализ контента в автоматическом режиме и систематизирует его;

-

пользователь получает подробный отчет в заранее выбранном формате.

Эта процедура использования парсера описана лишь в общих чертах, поскольку каждая утилита уникальна и этапы введения данных могут немного различаться. Помимо этого, на процесс работы парсера могут повлиять и цели, преследуемые пользователем.

Как парсить структуру сайта

Парсинг структуры - очень полезное занятие для тех, кто хочет разобраться в том, как устроен интернет-ресурс конкурента. Для этого необходимо сделать анализ breadcrumbs (хлебных крошек):

-

наведите курсором на любой элемент breadcrumbs;

-

нажмите правой кнопкой мыши и скопируйте XPath.

Далее такие действия необходимо выполнить и для других элементов структуры.

Парсинг интернет-магазина

Именно владельцы интернет-магазинов наиболее часто используют утилиты для автоматического сбора данных. В этом направлении можно решить сразу 2 важных задачи:

-

актуализацию информации о стоимости товарной единицы;

-

парсинг каталогов с сайтов поставщиков и конкурентов.

В первом случае Вам может прийти на помощь такая утилита, как Market Parser (но можно использовать и другие). В программе необходимо указать код продукта и она самостоятельно соберет всю нужную информацию с предложенных заранее сайтов. Большая часть процесса будет протекать без Вашего участия. Для того, чтобы увеличить эффективность анализа, ограничьте область поиска цен только страницами товаров.

При парсинге базы каталогов с сайтов конкурентов (поставщиков), необходимо отыскать код товара и указать его в парсере. Для того, чтобы упростить весь процесс сбора информации, разработчики придумали большое количество специальных приложений, созданных для автоматического сбора информации о товарах в онлайн-магазинах.

Как парсить иллюстрации и фото

Крупные интернет-магазины обычно размещают на своих сайтах фото поставщиков: они универсальны и могут использоваться в любом каталоге.

Специалисты собирают в таблицы все ссылки на картинки из разных карточек товаров, чтобы в дальнейшем выбрать нужный файл и загрузить его на собственный ресурс.

Большинство CMS разрешают прикреплять ссылки вместо стандартной загрузки файла. При помощи таких движков вы сможете “заливать” изображения прямо из CSV - файла.

Для того, чтобы запустить парсинг изображений, выделите необходимый код и правильно сформулируйте XPath-запрос:

-

правой кнопкой мыши нажмите на фото и кликните на “Посмотреть код объекта”;

-

вручную найдите код объекта и выделите в элементе <span> нужный тег;

-

сформулируйте XPath-запрос следующим образом: //*[@id="firstbackground-position"]/*/img/@src

Этот запрос обращен к идентификатору firstbackground-position — первой фотографией из списка, а также вложенным в него элементам, которые перечислены под *. Мета-тег img указывает парсеру на строку с URL-адресом, где брать информацию;

-

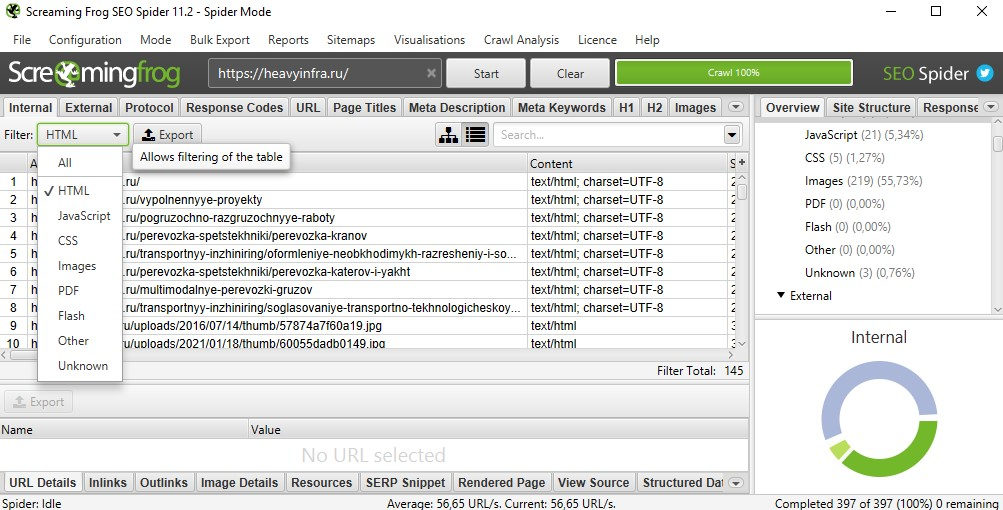

откройте парсер Screaming Frog (или любой другой) и перейдите во вкладку Configuration → Custom → Extraction, где необходимо вставить готовый запрос и нажать кнопку ОК.

Именно так можно спарсить одну фотографию или целый каталог:

-

для добавления единственного фото необходимо скопировать ссылку и вставить ее в парсер Upload → Paste;

-

для того, чтобы скопировать ссылки по всем имеющимся изображениям, находящихся на ресурсе, для начала выберите вкладку Mode → Spider, введите ссылку и запустите программу.

При сборе изображений не нужно конкретизировать страницы, поскольку парсер пропускает те разделы, в которых отсутствуют фото.

Если собранные изображения нужно идентифицировать по артикулу или названию, необходимо добавить еще один XPath-запрос. Многие специалисты делают следующим образом: они собирают целую связку, которая состоит из:

-

наименования товара (H1);

-

артикул;

-

фото.

Как парсить описание товаров

Перед тем, как совершить покупку, покупатели всегда читают описание товаров. И чем больше основных характеристик перечислит продавец, тем больше вероятность, что клиент оформит заказ.

Собирать все данные вручную - практически невозможно. Это займет у вас очень много времени. А автоматизировать процесс и свести все полученные данные в таблицу Excel можно также при помощи парсера.

Последовательность ваших действий будет практически такая же, как и при парсинге изображений:

-

нажмите правой кнопкой мыши на характеристику, которую хотите выделить;

-

кликнуть “Посмотреть код объекта” и найти строку с HTML-кодом.

Описание может находиться под тегом <span>. Технические характеристики и описания к ним указаны внутри элемента.

Далее введите необходимые параметры в парсер и программа соберет все указанные характеристики, под выбранным вами тегом.

Парсинг других страниц сайта

Принцип поиска информации на других страницах интернет-ресурсов практически ничем не отличается от парсинга каталогов или цен. Для начала необходимо запустить утилиту и внести туда код нужных элементов, а затем - запустить парсинг.

Вся существенная разница заключается лишь в первоначальной настройке. При вводе данных в программе необходимо указывать программе, что рендеринг осуществляется с JavaScript. Это нужно для анализа комментариев или статей, появляющихся на странице только после ее прокрутки. При включении такой настройки, парсер выполнит имитацию этого действия.

Обзор лучших парсеров

Все существующие парсеры можно условно разделить на 3 большие группы:

-

в виде облачных сервисов;

-

в виде компьютерных приложений;

-

в виде браузерных расширений.

Под облачными парсерами обычно подразумевают приложения или веб-сайты, на которых пользователь вводит некоторые параметры для поиска определенной информации. Оттуда этот запрос попадает на сервер компаниям, занимающимся услугами парсинга. После чего на этом же ресурсе выдается вся найденная информация.

Преимущество такого метода парсинга заключается в том, что вам не придется устанавливать на свой ПК дополнительную утилиту. А еще на таких сайтах обычно есть API, которое позволяет настроить поведение парсера под конкретные нужды. Однако настроек в нем намного меньше, нежели в версиях для ПК.

Наиболее популярными облачными парсерами на сегодняшний день стали:

-

Import.io В нем содержится наиболее востребованный набор инструментов для поиска контента на различных ресурсах. Он позволяет парсить неограниченное количество страниц, а также поддерживает все популярные форматы вывода данных. Он автоматически создает максимально удобную структуру для восприятия информации.

-

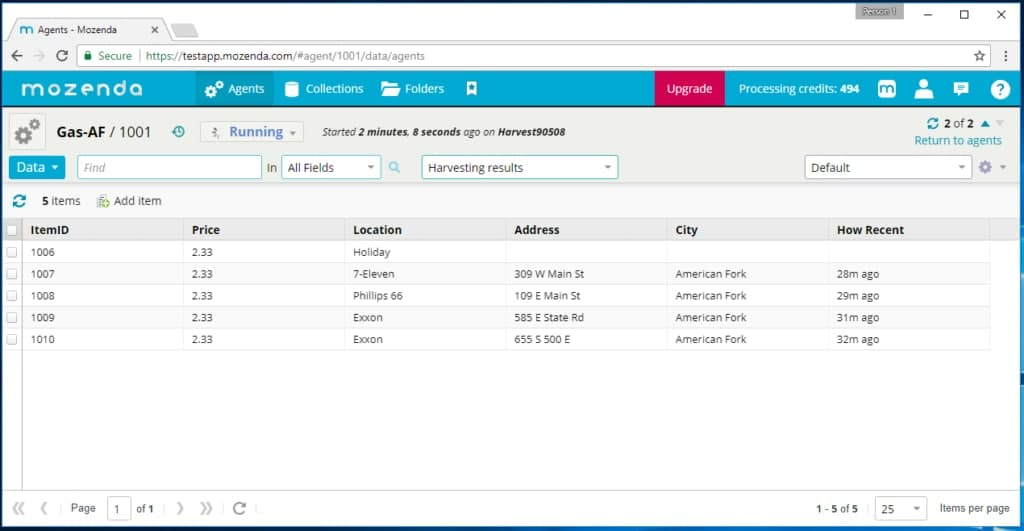

Mozenda - является сайтом для сбора информации, которому доверяют даже крупные знаменитые компании. При помощи него можно собрать любые типы данных, которые программа сконвертирует в необходимый для вас формат. Однако есть ограничение в использовании - бесплатный срок пользования составляет 30 дней.

-

Octoparce. Главным преимуществом данного парсера является его простота в использовании. Для того, чтобы его освоить, вам не придется изучать программирование и постоянно разбираться с непонятными кодами. Всю необходимую информацию можно заполучить всего лишь в пару кликов.

-

ParseHub - один из немногих парсеров, который работает абсолютно бесплатно и имеет достаточно широкий функционал.

В сети можно встретить очень много подобных облачных решений (как платных, так и бесплатных), однако вышеперечисленные сервисы пользуются наибольшей популярностью среди всех остальных.

Парсеры, предназначенные для ПК могут быть в виде компьютерных приложений. Но большая их часть предназначена для установки на Windows. Другими словами, если у Вас Linux или macOS, вам придется воспользоваться средствами виртуализации или же запустить виртуальную машину Windows, как обычно это делают с операционной системой Apple. Другой вариант - установка специальной утилиты (Wine), которая актуальна для любого дистрибутива Linux. Однако для такого способа данных потребуется достаточно мощный процессор компьютера.

Наиболее популярными парсерами среди компьютерных версий стали:

-

ParserOk. Это приложение предназначено для различных типов парсинга данных. В нем есть как настройка сбора данных о стоимости товаров, так и настройки для автоматической компиляции адресов электронной почты, каталогов, номеров и т.д.

-

Datacol представляет собой универсальный парсер с достаточно простым интерфейсом, который, по словам разработчиков, способен заменить решения конкурентов.

-

Netpeak Spider данный продукт станет отличным помощником в проведении SEO-аудита сайта. Позволяет выполнить простой парсинг сайта за считанные минуты.

-

Screaming Frog является мощным инструментом для SEO-специалистов. При помощи него можно собрать большое количество необходимой информации и провести полный аудит ресурса (просмотреть структуру сайта, найти ошибки страниц и т.д.). Без лицензии вы сможете проанализировать до 500 страниц бесплатно.

Представленные выше утилиты стали наиболее популярными среди пользователей. Они имеют демо-версию, которая поможет проверить все возможные функции до приобретения программы. Также существуют и бесплатные варианты парсеров для ПК, однако они намного хуже по качеству и могут уступать даже облачным решениям.

Самым удобным, но менее функциональным вариантом стали парсеры в виде браузерных расширений. Их преимущество заключается в том, что начать процесс парсинга можно прямо на той странице, откуда нужно вытащить необходимые данные и не приходится вводить дополнительные параметры вручную.

Но такие дополнения не имеют такого функционала, как утилиты для ПК. Это происходит потому, что расширения просто не способны собрать полный объем данных. Однако для быстрого анализа данных и экспорта в формате XML такие дополнения прекрасно подойдут.

Наиболее популярными среди таких расширений стали:

-

Parsers - представляет собой плагин для извлечения данных, импортирующий их в формат JSON или XML. Данное расширение автоматически запускается с нужной страницы и разыскивает похожие страницы с последующим сбором информации.

-

Scraper - способен собирать информацию в автоматическом режиме, но сильно ограничивает количество собираемых данных.

-

Data Scraper - это дополнение способно экспортировать все собранные данные в таблицы Excel. Оно отсканирует до 500 страниц бесплатно, а за большее количество придется уже регулярно доплачивать.

-

Kimono представляет собой расширение, которое превратит абсолютно любую страницу в структурированное API для извлечения необходимых данных.

Другими словами можно сказать, что парсеры - это такие сервисы, которые способны сэкономить наше время и отдать максимальное количество необходимой информации за считанные минуты. Однако для того, чтобы получить нужные данные, необходимо подобрать правильную утилиту. Чтобы это сделать правильно, для начала нужно ответить на несколько основных вопросов:

-

Зачем мне нужен парсер?

-

В каком виде хочу получить данные?

-

Как часто необходимо делать выгрузки?

И только после того, как вы ответите на эти основные вопросы, просмотрите несколько подходящих для ваших целей приложений и изучите отзывы пользователей.